Par Denis Trystram, Université Grenoble Alpes (UGA); Romain Couillet, Université Grenoble Alpes (UGA) et Thierry Ménissier, Université Grenoble Alpes (UGA)

Depuis une dizaine d’années, l’essor considérable du monde numérique et en particulier de l’intelligence artificielle a eu des effets spectaculaires dans quelques domaines scientifiques, tels que la vision par ordinateur (pour la détection automatique d’objets, de visages) ou le traitement du langage naturel (traduction automatique, filtres antispam, suggestions de réponses automatiques).

Aujourd’hui, on imagine ce développement capable de bouleverser tous les autres champs de la société. On nous promet un avenir radieux fait de bien-être et de confort améliorés par la santé digitale, les véhicules autonomes, les interfaces humains-machines sophistiquées, les robots pour l’aide à domicile, ou encore les visites virtuelles de tous les musées du monde portant toute la culture humaine à portée de clics.

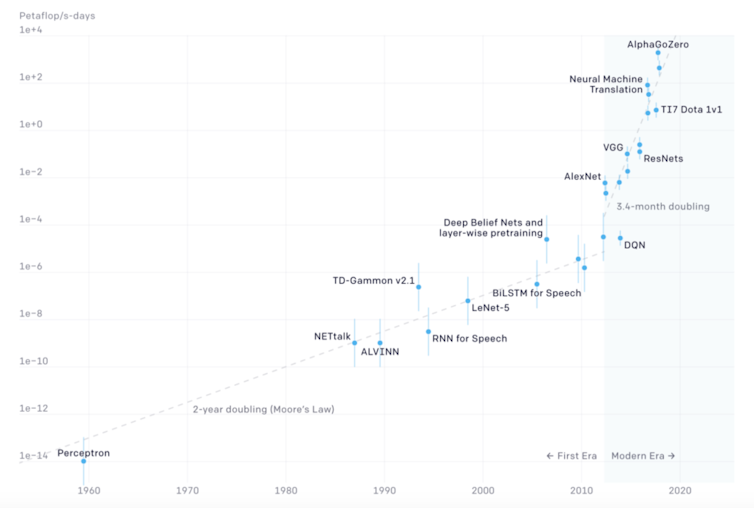

En tête de proue de cet essor se trouve l’apprentissage profond (ou deep learning en anglais), ces fameux « réseaux de neurones artificiels » qui se sont vite diffusés. Cependant, le coût énergétique de cet outil technique est peu connu des utilisateurs alors qu’il est particulièrement préoccupant.

Au-delà des questions de performances, de rapidité ou de passage à l’échelle qui intéressent les ingénieurs en quête de toujours plus de prouesses technologiques, c’est d’un point de vue environnemental, et en particulier sur le plan des émissions de gaz à effet de serre que la question inquiète.

Une consommation énergétique impressionnante

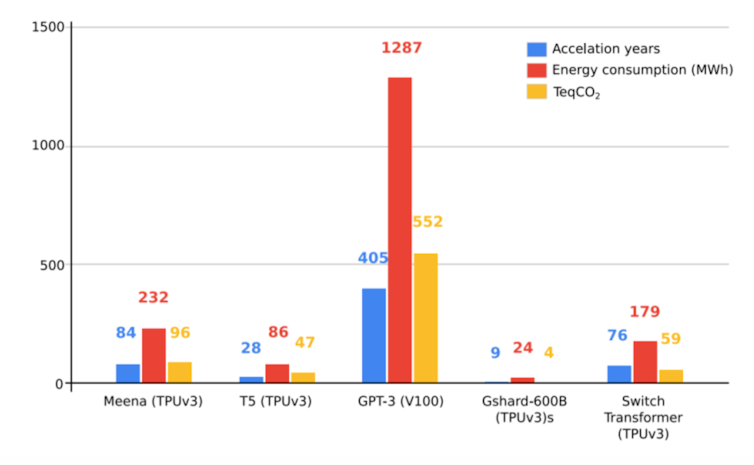

Concrètement, la consommation énergétique d’une seule exécution d’entraînement (en général il en faut plusieurs pour obtenir un résultat abouti) des réseaux de neurones artificiels les plus récents, dédiés au traitement naturel du langage, dépasse le million de kilowatts-heures dépensés au bout de plus d’un mois de calculs sur des machines équipées de quelque 10 000 processeurs, parmi les plus puissantes actuelles.

Côté porte-monnaie, la facture électrique excède les 100 000 euros et pour la planète plus de 500 tonnes d’émissions de CO2, soit une empreinte carbone équivalente à 500 vols aller-retour Paris-New York. En comparaison, le cerveau humain consomme en un mois environ 12 kWh, soit cent mille fois moins, pour des tâches bien plus complexes que la traduction en langage naturel.

Contrairement à dix ans plus tôt, il est d’ailleurs aujourd’hui devenu inenvisageable d’entraîner un réseau de neurones comme celui que l’on vient d’évoquer sur notre ordinateur de bureau (cela prendrait théoriquement 405 ans). En clair, l’intelligence artificielle est une réelle révolution numérique, mais une révolution qui coûte extrêmement cher.

Un danger pour l’équilibre planétaire ?

Il n’est en fait pas surprenant que des solutions « d’intelligence informatique » soient bien moins énergétiquement efficaces que trois milliards d’années d’évolution biologique. Ce qui choque avant tout, c’est que la consommation absolue atteint des seuils indécents, à une époque où le poids du dérèglement climatique exige de la société des hommes un vif effort de sobriété énergétique.

Bien sûr, « une fois entraîné » l’algorithme sera réutilisé des millions de fois par nos téléphones ou nos voitures à un coût comparativement négligeable. Mais le développement de l’intelligence artificielle s’est accompagné du déploiement fulgurant et toujours croissant de clusters de calculs dédiés à l’apprentissage et d’infrastructures réseau aujourd’hui dissimulés dans la nébuleuse du cloud mondial.

Cette virtualisation du calcul loin de l’ordinateur de bureau de l’ingénieur moderne induit au passage cette nouvelle illusion d’un caractère « inoffensif » de l’intelligence artificielle. En réalité, la fabrication et l’usage de ce cloud – qui n’est nullement immatériel – engendrent des centaines de tonnes de CO2 additionnelles (cycle d’extraction de métaux, transformation, transport, usage).

Cette fuite en avant sur le décompte des émissions de CO2 ne saurait d’ailleurs être complète si l’on oublie d’évoquer le problème des déchets électroniques majoritairement non recyclables. Ils devraient être traités à la fin de vie de ces matériels mais ne le sont en réalité qu’à hauteur de 17 % (un smartphone contient plus de 50 métaux devenus impossibles à désolidariser).

Un contexte qui invite à la sobriété

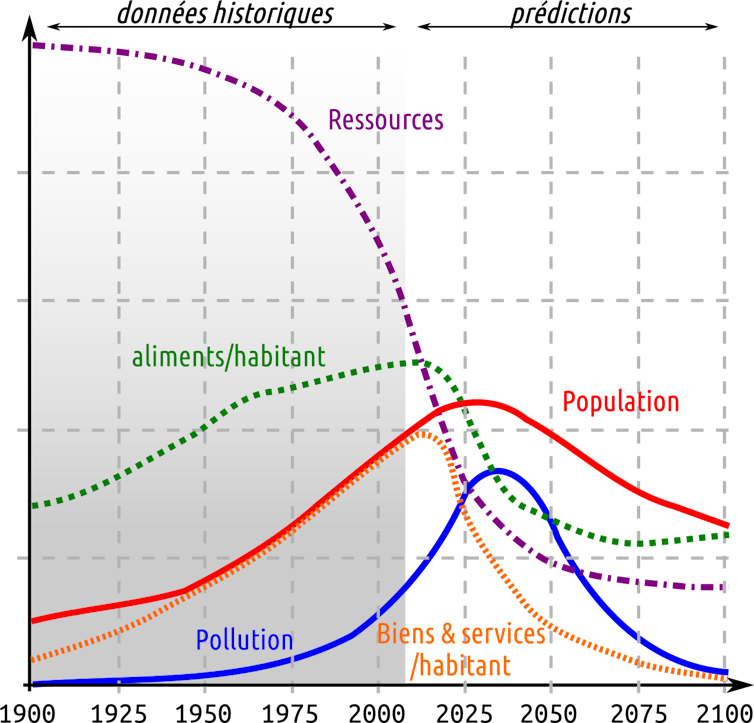

Il est désormais acquis rapports du GIEC à l’appui, que le volume des rejets de CO2 dans l’atmosphère et la dégradation de la biosphère induits par les activités humaines des cinquante dernières années menace la stabilité du système Terre.

Dans le scénario où l’humanité conserverait sa trajectoire actuelle, les études envisagent un effondrement de la société et de la vie sur Terre entre 2025 et 2050. Pour nombre d’auteurs, la seule réponse viable est d’engager notre civilisation dans une diminution drastique (5 % à 7 % par an pendant 30 ans) de la production de biens et services puisés directement ou indirectement à la planète – minerais, eau, vivant – et dans une refonte de la symbolique de « croissance ».

Ceci pose naturellement la question de ce qui doit être supprimé ou réduit de la pression industrielle qui pèse sur la planète ainsi que des stratégies socialement acceptables pour atteindre ces objectifs.

Dans le cas de l’intelligence artificielle et de l’apprentissage profond, la réflexion à mener est la suivante.

Gadget ou besoin indispensable ?

L’intelligence artificielle s’est propagée au point de toucher des domaines traditionnels qui reposent pourtant sur des modèles mathématiques solides (finance, sismologie, biologie, etc.). Dans un monde fortement contraint par des limites énergétiques et en proie à une pollution galopante, la question se pose de la plus-value réelle des innovations pour ces nouveaux venus.

Mais le gros de la dépense des applications du numérique et de l’intelligence artificielle se trouve hors des laboratoires de recherche : il se concentre dans les usages technologiques dédiés aux loisirs et aux appareils de confort, que notre civilisation invente tous les jours et qui passent trop vite du statut de gadgets à celui de besoins supposés indispensables. Devant le constat de l’état du monde, n’est-il pas évident, sinon un devoir moral, dans cette nécessaire croissance symbolique où primerait la protection de la nature et du vivant, de commencer par renoncer à la plupart de ces gadgets et de focaliser nos efforts sur des pratiques plus vertueuses ?

On ouvre de fait une réflexion sur les compromis. Comparer la pertinence d’outils ayant produit des progrès sociaux n’est pas facile, d’autant qu’elle intègre des paramètres non techniques (d’ordre social, éthique ou psychologique). Une fois les outils vertueux identifiés, ils devront d’ailleurs nourrir une éthique attentive aux nouveaux impératifs, tâche pour laquelle il est déjà possible de s’appuyer sur les pionniers de l’éthique environnementale.

L’intelligence artificielle moderne fait-elle alors partie de ces outils vertueux ?

La difficile émergence de la « low tech »

Dans l’anticipation d’une énergie plus rare, les technologies dont l’étude elle-même est onéreuse deviennent non soutenables. Dans le cadre de l’intelligence artificielle, on peut anticiper un point prochain de bascule où les coûts de la recherche en intelligence artificielle prendront le pas sur les gains de performance, aussi conséquents soient-ils, apportés par les réseaux de neurones.

Ce constat sonne-t-il pour autant le glas de l’intelligence artificielle ? Pas forcément. Mais peut-être faut-il l’aborder avec un regard neuf. Un exemple éloquent dans ce sens est celui du travail du Dr d’Acremont en Tanzanie qui démontre sur le terrain l’intérêt, en matière de résilience et de performance, d’une technologie « low-tech » (qui n’utilise même plus d’ordinateur), cependant initialement construite sur un modèle d’intelligence artificielle « high-tech ».

Comme l’illustre parfaitement le Dr d’Acremont, tout l’enjeu repose ici sur notre capacité à extraire de ces brillantes machines une interprétabilité suffisante pour parvenir à exploiter leurs résultats tout en se passant au final de la machine elle-même. Et ce, dans le but de se préparer au moment où, tôt ou tard, il faudra peut-être abandonner définitivement l’outil.

Elles ne font pas la une des journaux mais on voit déjà émerger des démarches sobres et efficaces d’intelligence artificielle, qui entrent globalement dans le mouvement vertueux vers une économie symbiotique (cette économie radicalement nouvelle qui s’appuie sur la résilience et la génération « gratuite » de ressources par la nature) et un outillage low-tech.

En dépit d’une réelle sensibilité à l’éthique manifestée par les concepteurs de l’intelligence artificielle, ces idées restent difficilement valorisables dans les conférences académiques ou les grands appels à projets. Il est en particulier délicat aujourd’hui pour un jeune chercheur ou ingénieur d’envisager positivement l’avenir en se soustrayant à l’appel de l’apprentissage profond.

Ce constat est d’autant plus alarmant que ces jeunes talents sont érigés en sauveurs d’une planète que leur travail au quotidien œuvre à dégrader. Cette dissonance cognitive forte provoque de nouvelles maladies de civilisation que sont l’écoanxiété et la solastalgie.

En définitive, s’il est admis que la finalité de la recherche en intelligence artificielle, au même titre que toute autre forme de recherche, est d’améliorer les connaissances afin de contribuer au progrès et de maximiser le bien-être collectif, il est regrettable que nous mettions délibérément en péril la survie de l’humanité et annihilions l’engagement de nos jeunes talents alors que des alternatives plus vertueuses et moins coûteuses sont à portée de main.![]()

Denis Trystram, Professeur des universités en informatique, Université Grenoble Alpes (UGA); Romain Couillet, Professeur des universités, spécialisé en mathématiques appliquées et intelligence artificielle, Université Grenoble Alpes (UGA) et Thierry Ménissier, Professeur de philosophie politique, Université Grenoble Alpes (UGA)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.