Par Constantin Pavléas, avocat spécialisé en droit des nouvelles technologies, fondateur et dirigeant du cabinet Constantin Pavléas Avocats et professeur et coordinateur du programme Droit du Numérique & Propriété Intellectuelle et responsable d'enseignements à l'école des Hautes Études Appliquées du Droit (HEAD).

Les pays du G7 ont adopté un code de bonne conduite sur l’intelligence artificielle (IA). Ce texte comprend 11 recommandations non contraignantes en faveur d’une IA « sûre, sécurisée et digne de confiance ». Les risques posés par l’IA apparaissent dans ce texte comme énormes.

Il ne faut cependant pas perdre de vue que l’IA est un outil, qui peut être utilisé à bon ou à mauvais escient. Nous ne devons pas jeter le bébé avec l’eau du bain. Petit tour d’horizon…

Le meilleur de l’IA…

Dans le secteur de la santé, l’IA est pleine de promesses, en permettant notamment le suivi des patients à distance, l’anticipation de certains risques ou le développement de maladies, la création de prothèses intelligentes, l’amélioration des diagnostics, le traitement personnalisé par le recoupement de données… Ces domaines sont en pleine expansion et l’IA devrait jouer un rôle crucial dans la médecine de demain, dont nous ne devons pas nous priver.

L’IA peut faciliter l’apprentissage grâce aux objets intelligents, aux cours en ligne et des formations optimisées permettant d’accomplir des tâches plus complexes ou de gagner plus rapidement en compétences.

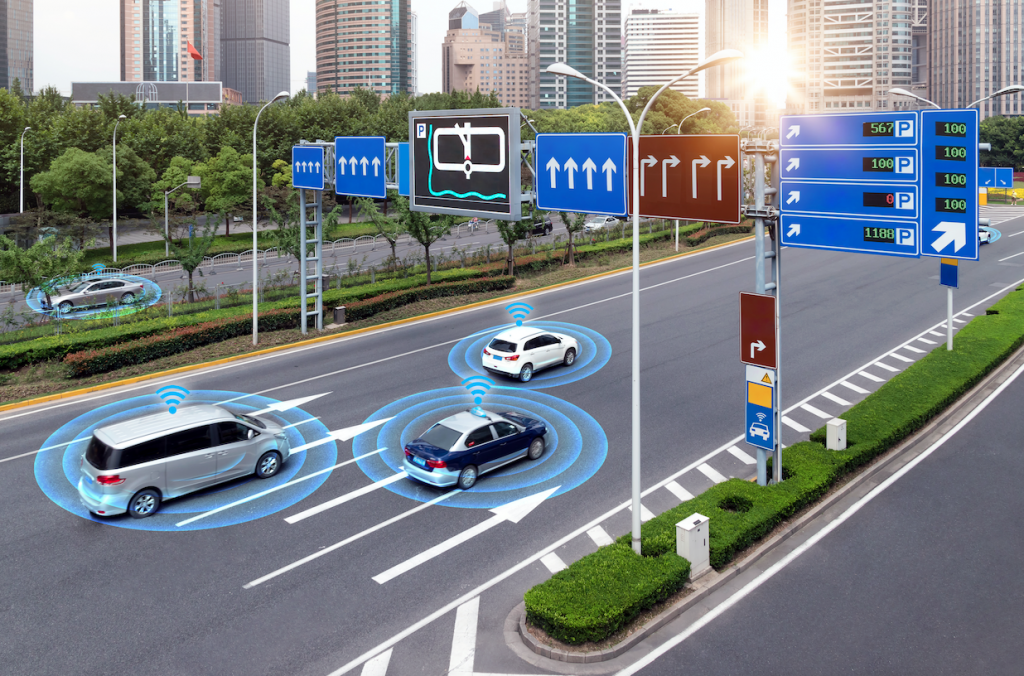

L’IA permet de rendre les transports plus intelligents grâce à la détection de l’environnement du conducteur, la prise en charge de la conduite semi-automatique voire autonome, détection des lignes blanches, etc.

L’IA peut aussi aider tout un chacun dans son quotidien, permettant d’accéder à des informations plus facilement, de bénéficier de recommandation de contenus qui nous correspondent ou pourraient nous intéresser, ou d’assistants vocaux permettant d’accomplir certaines tâches par l’utilisation de la voix.

Le pire de l’IA…

Comme le souligne le texte du G7, l’IA présente aussi certains risques, et c’est pourquoi elle doit être encadrée :

- L’IA peut présenter une menace en matière de protection de la vie privée et d’utilisation des données personnelles

- Elle peut aussi être utilisée à mauvais escient en permettant la création et la prolifération de fausses informations et de deepfakes (photos manipulées, etc.), mais aussi d’images pédopornographiques ou autres photos réalisées sans le consentement de la personne via certaines applications.

- D’après la note du G7, particulièrement alarmante, l’IA pourrait aussi faciliter le développement des armes chimiques, biologiques ou nucléaires, en permettant à des acteurs non-étatiques d’y accéder

- Enfin, l’IA n’est pas infaillible et peut également commettre des erreurs, en raison notamment de biais algorithmiques. Elle ne détient pas de conscience humaine et il est important que les êtres humains continuent à maîtriser cette intelligence.

Pour ces différentes raisons, l’Union européenne s’est emparée du sujet avec son projet de règlement IA Act, mis sur la table en avril 2021. Un accord devrait être trouvé entre les différents pays européens d’ici fin 2023. Il s’agirait de la première législation mondiale pour encadrer l’IA. Cela démontre une conscience européenne face à ces enjeux et des valeurs européennes de liberté et de démocratie à préserver, y compris dans l’espace numérique.

Le fait que les États-Unis soient désormais moteurs pour traiter le sujet au niveau du G7 montre à la fois la gravité des enjeux suscités par l’avènement de l’IA grand public et, enfin, une prise de conscience à l’échelle mondiale.