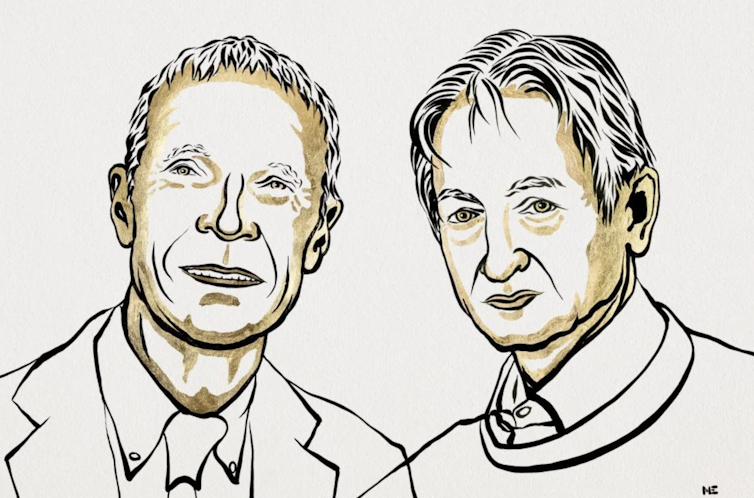

Aux sources de l’IA : le prix Nobel de physique attribué aux pionniers des réseaux de neurones artificiels et de l’apprentissage machine

Le prix Nobel de physique 2024 récompense des travaux précurseurs de John Hopfield et Geoffrey Hinton sur les réseaux de neurones artificiels, à la base de l’apprentissage machine. Ces travaux ont participé au développement de l’intelligence artificielle, qui chamboule aujourd’hui de nombreux secteurs d’activité.

C’est à une question simple que John Hopfield et Geoffrey Hinton ont apporté une réponse qui leur vaut aujourd’hui le prix Nobel de physique : « Quelle est la description la plus simple que nous pourrions faire de nos neurones, ces composants du cerveau, siège de notre intelligence ? »

Un neurone, qu’il soit artificiel ou biologique, est une petite unité de calcul, qui prend des valeurs en entrée, les combine très simplement (un simple calcul de moyenne pondérée avec des coefficients comme les notes du bac, ces paramètres permettant d’ajuster le fonctionnement de cette unité) et applique une transformation sur le résultat (par exemple en ne gardant que les valeurs positives, ou en regardant si le résultat est au dessus ou au dessous d’un seuil).

Le point levier est qu’en combinant un très très grand nombre de telles unités, sur plusieurs couches, parfois avec des boucles, on a pu démontrer que l’on pouvait approximer tous les calculs possibles, même les plus complexes.

Avec les propositions initiales, dès les années 1950, il eut fallu un nombre rédhibitoire de ces « neurones » artificiels, pour faire des applications utiles.

Mais au fil des années et des travaux d’ingénierie en informatique, par exemple avec les travaux de Yann LeCun, on a pu arriver à une si grande efficacité, que ces monstres de calcul peuvent transformer notre parole en texte, catégoriser des images, donner des résultats statistiques sur toutes sortes de données humaines, y compris médicales, juridiques et… militaires. Les travaux des lauréats sont non seulement fondateurs, mais ont aussi inspiré des travaux avec de nouvelles architectures qui ont pu mener aux performances d’aujourd’hui.

Comment ajuster les milliards de paramètres de toutes ces unités de calcul ?

Chaque unité de calcul — chaque neurone — est donc définie par des paramètres qui pondèrent les entrées prises en compte. Mais comment les ajuster ?

C’est la question majeure : notre cerveau, avec presque 100 milliards de neurones et près de 10 000 fois plus de connexions (donc millions de milliards) donc autant de paramètres à ajuster (en prenant les choses au plus simple), a mis plusieurs millions d’années, de génération en génération, pour obtenir les connexions actuelles qui font émerger notre intelligence. Et consomme aujourd’hui à peu près l’équivalent d’une unique ampoule électrique.

En regard, ce sont quelques milliards de paramètres qui sont ajustés pour entraîner les plus gros réseaux de calculs artificiels, comme les agents conversationnels. Et ceci se fait au prix de consommations énergétiques colossales et clairement préjudiciables.

De plus, pour ajuster ces paramètres, il faut des milliards de données, chaque lot de données permettant de modifier progressivement les paramètres pour que le résultat obtenu corresponde au mieux au résultat attendu.

Avec les réseaux de neurones, on ne programme plus en changeant l’algorithme, mais en ajustant l’architecture d’un algorithme universel et ses paramètres avec des données.

Et cela bouleverse le monde à plusieurs niveaux

Tout d’abord parce que ces algorithmes, qui ne sont finalement que d’aveugles calculs statistiques sans aucun sens des choses, sont néanmoins « déraisonnablement » efficaces pour traiter un problème précis et surpassent la capacité de notre cerveau à prendre en compte de telles masses de données. Nous avons mis au point des outils qui vont au-delà de la partie « mécanique » de nos capacités cognitives, mais que nous devons utiliser en gardant notre discernement et notre libre arbitre humain.

Ensuite, parce que les machines qui exécutent ces algorithmes sont gigantesques, cela crée à la fois un enjeu environnemental majeur, et des fractures socio-économiques entre qui peut assumer de tels coûts (en milliards d’euros) et qui n’en dispose pas.

Cela questionne également notre propre intelligence humaine : que veut dire être intelligent, au fond ? Avec ces algorithmes, beaucoup de ce que nous pensions « intelligent » de la part de notre cerveau, n’est peut-être qu’un simple calcul statistique. Et à l’inverse, croire qu’une intelligence artificielle générale va singulièrement apparaître n’est pas une prédiction scientifique, mais reste — et restera — du domaine de la croyance.

« L’intelligence artificielle est ce que nous pouvons faire faire à une machine et qui aurait été intelligent si cela avait été fait par un humain » Marvin Minsly, co-fondateur de l’intelligence algorithmique, dite « artificielle » (Scientific conference at Dartmouth College, 1956)

Thierry Viéville, Directeur de Recherche Inria en charge de la médiation scientifique, Inria

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.