Pour mieux comprendre l’ordinateur quantique et la course technologique qu’il génère, nous vous proposons ici le second opus de notre série. Après un premier article sur la naissance du concept d’ordinateur quantique, nous explorons ici comment il pourrait être réalisé en pratique et les défis scientifiques et technologiques à relever.

Le prix Nobel de physique 2022 vient d’être décerné à trois pionniers de l’information quantique, dont un Français, Alain Aspect. Leurs travaux ont posé les bases de la « seconde révolution quantique », qui permet de rêver à la réalisation d’un ordinateur quantique.

De fait, l’ordinateur quantique fait des apparitions de plus en plus remarquées dans la presse généraliste, et nombreux sont les lecteurs qui pourraient en déduire que l’humanité dispose déjà d’instruments surpuissants capables de battre à plate couture nos bons vieux ordinateurs.

En effet, en se basant sur les principes fondamentaux de la physique quantique, les chercheurs et les industriels conjuguent leurs efforts pour réaliser l’ordinateur quantique ultime, dit « universel ». Et s’il est vrai que les accomplissements récents dans le domaine sont aussi impressionnants que prometteurs, avec à ce jour, le plus gros ordinateur quantique annoncé contenant 127 « bits quantiques », il faut bien voir que ce dernier n’a pas été conçu pour être capable de réaliser des calculs utiles, mais comme une « preuve de concept ».

Ainsi, à l’heure actuelle, un ordinateur quantique universel opérationnel reste un Graal inaccessible, dont personne ne peut encore prédire la réussite avec certitude.

En revanche, nous sommes déjà sur le point de disposer de machines quantiques plus petites, appelées « simulateurs quantiques », qui seront utiles pour résoudre des problèmes spécifiques en physique, en ingénierie, en chimie ou encore en pharmaceutique.

La promesse quantique

Un ordinateur quantique « universel » pourrait en théorie effectuer tous les calculs que peut faire un ordinateur classique, mais plus efficacement. En réalité, ceci ne sera possible que pour certains calculs, qui mettront en œuvre des algorithmes spécifiquement conçus pour l’informatique quantique. L’ordinateur quantique rendrait alors possibles des calculs aujourd’hui infaisables parce qu’ils prendraient trop de temps.

Par exemple, des milliers de milliards d’années seraient nécessaires sur un supercalculateur dernier cri pour factoriser des nombres à quelques centaines de chiffres, comme ceux utilisés pour sécuriser nos communications, mais il faudrait seulement quelques heures à un ordinateur quantique de taille modeste pour résoudre ce problème.

Comment construit-on un ordinateur quantique ?

Encore faut-il construire un ordinateur quantique qui fonctionne avec les algorithmes quantiques conçus exprès pour lui.

Un ordinateur quantique est une machine qui incorpore des « qubits » – l’équivalent quantique des « bits », unités de calcul classique – et qui permette de les manipuler afin de réaliser les opérations requises par l’algorithme. Ainsi, les qubits doivent suivre les lois de la physique quantique.

Les premiers candidats au rôle de qubit sont donc des particules quantiques individuelles. En effet, on sait aujourd’hui contrôler des atomes individuels avec des lasers, des ions avec des champs électromagnétiques, et des électrons avec des circuits électriques nanométriques.

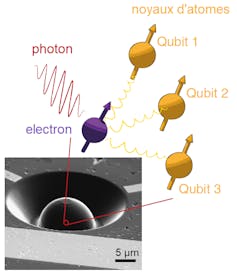

On peut aussi utiliser des particules de lumière, car on sait aujourd’hui émettre des photons un par un – des photons dits « uniques ». Pour cela, on utilise des « boîtes quantiques semi-conductrices », des défauts contrôlés par exemple dans du diamant, ou encore des cristaux dits « non linéaires ».

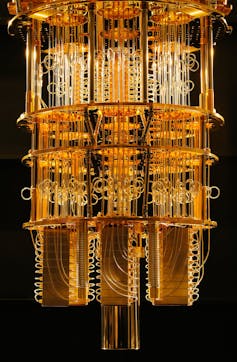

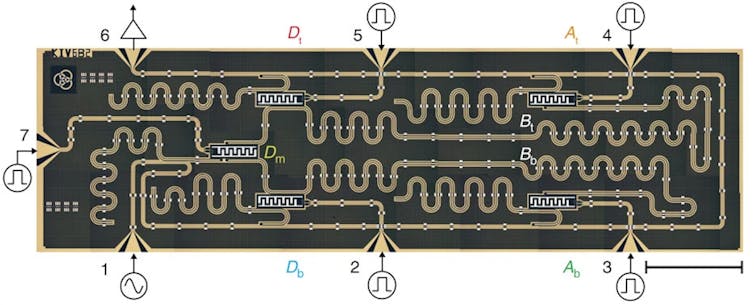

Une dernière option est d’utiliser comme qubits des circuits supraconducteurs : ce sont des circuits électroniques de taille millimétrique, bien plus grande que les réalisations basées sur les particules quantiques discutées ci-dessus. Elles offrent ainsi l’avantage de pouvoir être intégrés sur une puce au moyen des techniques similaires à la fabrication des ordinateurs classiques. C’est la voie retenue par les géants de l’informatique Google et IBM.

Contrôler les qubits individuellement, la « seconde révolution quantique »

La multitude de systèmes physiques pouvant matérialiser l’ordinateur quantique résulte en une recherche foisonnante dans tous ces domaines, qui progressent en parallèle. Ce contrôle des particules individuelles constitue ce qu’on nomme désormais la « seconde révolution quantique » – la première étant celle des technologies basées sur des ensembles de particules quantiques : lasers, transistors, supraconducteurs, qui ont transformé durablement notre monde durant la deuxième moitié du XXe siècle.

Malgré tous ces progrès, le contrôle de ces qubits reste beaucoup plus difficile que les bits classiques, à cause de la très grande fragilité des effets quantiques. En effet, l’environnement des constituants (c’est-à-dire la chaleur, la lumière, les champs électrique et magnétique par exemple) finit toujours par perturber les états de superposition et d’intrication. Ce phénomène, appelé « décohérence », limite en pratique la manipulation et le stockage de l’information contenue dans les qubits.

Pire… plus l’ordinateur comporte de qubits, plus cette perturbation est rapide. Pour ces raisons, les prototypes actuels sont réalisés dans des environnements extrêmes : très basse température (à quelques fractions de degrés du zéro absolu), ultravide, obscurité totale. Ces conditions très contraignantes, seulement réalisables en laboratoire, permettent de conserver les effets quantiques un certain temps, mais pas suffisamment pour être réellement opérationnels.

[Plus de 80 000 lecteurs font confiance à la newsletter de The Conversation pour mieux comprendre les grands enjeux du monde. Abonnez-vous aujourd’hui]

Une solution théorique existe : pour protéger l’information quantique, il faut répartir chaque qubit « logique » sur un très grand nombre de qubits « physiques » afin de pouvoir effectuer des corrections d’erreur. Dans cette approche, des millions de qubits seraient ainsi nécessaires pour un ordinateur quantique universel fiable et il faudrait fabriquer des ordinateurs quantiques démesurés pour compenser leurs imperfections.

Or, à l’heure actuelle, personne n’est capable de réaliser un tel ordinateur, et il est impossible de prédire s’il existera un jour.

Vers des ordinateurs quantiques spécialisés, ou « simulateurs quantiques »

Pourtant, au cours de la quête de l’ordinateur quantique universel, de nouvelles idées ont émergé.

Il paraît fort probable que les premiers ordinateurs quantiques seront bien différents des ordinateurs omnipotents imaginés au départ et seront plutôt pensés pour effectuer une tâche bien précise, constituant sans doute le moyen le plus efficace de la réaliser – voire le seul.

Les applications entrevues sont multiples, avec par exemple l’optimisation de réseaux de distribution, la compréhension des mécanismes de la photosynthèse, la conception de catalyseurs pour engrais, de médicaments, l’optimisation de batteries ou de cellules solaires.

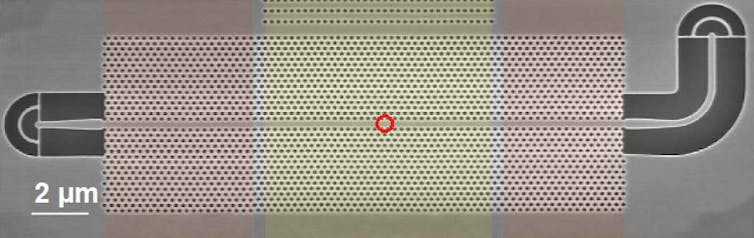

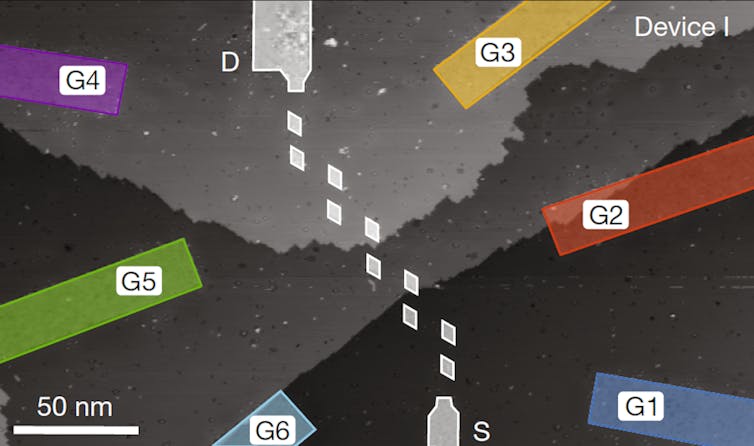

Pour illustrer ce principe par un exemple concret, une équipe australienne a réalisé cette année un petit processeur basé sur une dizaine de qubits en silicium, en piégeant des électrons entre des électrodes nanométriques. Ce circuit quantique a été conçu pour simuler des molécules de polyacétylène, une molécule qui présente un grand intérêt pour la physique fondamentale car elle matérialise un problème de physique théorique complexe, et qui a fait l’objet du prix Nobel de chimie en 2000.

Dans cette réalisation virtuose, la taille de la molécule simulée (10 atomes) est à la limite de ce qui est raisonnablement calculable avec un ordinateur classique. Cela a permis de vérifier les prédictions du processeur quantique.

Un processeur quantique deux fois plus grand, c’est-à-dire avec 20 qubits, surpasserait déjà de loin ce que nos capacités de calcul classiques pourraient simuler concernant ce type de molécules remarquables.

L’enjeu du passage à l’échelle

Pour atteindre un tel « avantage quantique », il faut augmenter le nombre de qubits dans les calculateurs.

Les dix à vingt dernières années ont vu la réalisation de nombreux prototypes de protocoles quantiques à deux ou quelques qubits – souvent spectaculaires. Les systèmes les plus avancés peuvent actuellement traiter quelques dizaines de qubits.

Outre les problèmes de « cohérence » déjà évoqués, la difficulté réside aussi dans la reproductibilité des systèmes physiques.

Prenons cette fois-ci l’exemple des photons. Les algorithmes quantiques nécessitent que ces particules de lumière soient toutes « indiscernables », c’est-à-dire qu’elles ont les mêmes caractéristiques, et notamment exactement la même longueur d’onde (la même couleur). Les meilleures sources pour cela sont les « boîtes quantiques », car les photons émis consécutivement par les meilleures boîtes quantiques sont tous identiques. Mais comme les photons émis par des boîtes quantiques distinctes sont généralement très différents. Pour réaliser un calcul quantique, on est donc contraint d’utiliser une seule et même boîte quantique, et d’utiliser les photons qu’elle a émis consécutivement. Cette contrainte complique l’architecture d’un futur ordinateur et limite le nombre total de qubits que l’on peut utiliser simultanément.

Des recherches sont actuellement menées par de nombreux laboratoires pour obtenir des sources contrôlées qui ont toutes la même longueur d’onde, ce qui permettra d’obtenir de grands nombres de photons identiques émis simultanément et de conserver une fréquence d’horloge élevée.

Quelle que soit la plate-forme physique choisie pour créer des qubits, il faudra pouvoir les manipuler et les mesurer en grand nombre, mais indépendamment les uns des autres. Et pour interfacer ces systèmes quantiques avec des contrôleurs classiques, il faut des systèmes miniaturisés, souvent nanométriques.

Ainsi, le passage à l’échelle de l’informatique quantique promet de donner du fil à retordre aux ingénieurs en électronique, en optique, ou encore en informatique… Même s’il est impossible de prédire si nous aurons un véritable ordinateur quantique « universel », l’informatique quantique fera sans aucun doute partie de notre futur et structurera durablement les sciences.![]()

Aymeric Delteil, Chercheur CNRS, Groupe d'étude de la matière condensée, Université de Versailles Saint-Quentin-en-Yvelines (UVSQ) – Université Paris-Saclay

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.