Le bilan provisoire du violent séisme qui a frappé le Maroc dans la nuit de vendredi à samedi ne cesse d’augmenter. Il est désormais de plus de 2 000 morts, a précisé le ministère de l’Intérieur.

Selon le Centre national pour la recherche scientifique et technique, l’épicentre de la secousse se situait dans la province d’al-Haouz, au sud-ouest de Marrakech et le tremblement de terre a provoqué d’importants dégâts dans plusieurs villes

Au cours des trente dernières années, les tremblements de terre et les tsunamis qu’ils génèrent ont causé la mort de près d’un million de personnes. Si la prédiction en tant que telle de ces événements est impossible, des systèmes d’alerte ont été mis en place pour limiter le coût humain et matériel de ces catastrophes.

Ces systèmes ne prédisent pas le futur, mais essaient de détecter les séismes et d’estimer le plus rapidement possible leur magnitude. Actuellement, ils utilisent les ondes sismiques pour tenter de prévenir les populations quelques secondes avant les secousses, même si malheureusement le résultat n’est pas toujours au rendez-vous.

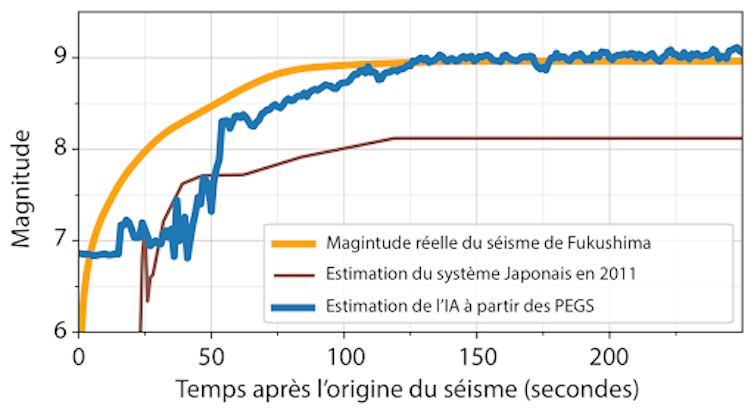

Les tsunamis se propagent plus lentement, laissant plus de temps pour agir ce qui est généralement (quelques dizaines de minutes). Cependant, les systèmes d’alerte éprouvent de grandes difficultés à évaluer rapidement la magnitude des très grands séismes. Par exemple, le système japonais a estimé une magnitude de 8 au lieu de 9 lors du séisme de 2011, et donc une vague de 3 mètres au lieu de 15, une erreur aux conséquences dramatiques à Fukushima.

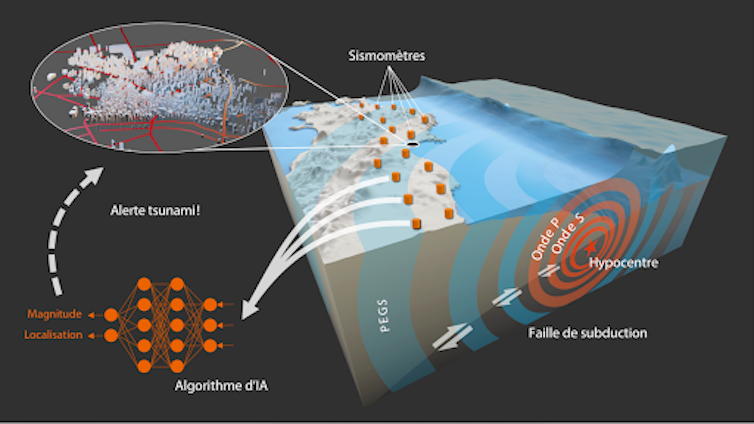

Afin d’améliorer les systèmes d’alerte sismique et tsunami, nous travaillons actuellement sur un algorithme d’intelligence artificielle (IA), basé sur des ondes d’origine gravitationnelle, qui estime de manière plus fiable et plus rapide la magnitude des grands séismes.

Les systèmes d’alerte sismique

Les signaux sismiques enregistrés le plus tôt sur les sismomètres sont les ondes de compression (dites ondes P). Ces ondes se propagent à environ 6,5 km par seconde. Si vous êtes 65 km plus loin de l’épicentre que les capteurs les plus proches, vous allez donc ressentir les premières secousses 10 secondes après que ces capteurs aient enregistré les premières ondes P. En pratique, en prenant en compte le temps de transmission et de traitement de ces ondes, vos 10 secondes seront probablement réduites à 5 ou 6.

Mais les ondes les plus destructrices, les ondes de cisaillements (dites ondes S), se propageant légèrement plus lentement que les ondes P (à environ 3,5 km par seconde), il est possible d’anticiper de quelques secondes les plus fortes secousses. Sur ce principe, dans les pays pourvus de systèmes d’alerte sismique comme au Japon, lorsqu’un séisme est détecté proche de votre position, vous recevez un SMS d’alerte vous informant de l’imminence de secousses.

Les systèmes d’alerte tsunami

Malheureusement, pour des raisons à la fois instrumentales et fondamentales, les ondes P ne renseignent pas de manière fiable sur la magnitude des très grands séismes. Les systèmes d’alerte sismiques, basés sur ces ondes, s’avèrent ainsi incapables de faire la différence entre un séisme de magnitude 8 et un séisme de magnitude 9, posant un problème majeur pour l’estimation du tsunami, comme l’a illustré l’exemple de Fukushima en 2011. En effet, un séisme de magnitude 9 est 30 fois plus « grand » qu’un séisme de magnitude 8, le tsunami qu’il génère est donc considérablement plus important.

Pour estimer de manière plus fiable la magnitude des grands séismes, des systèmes d’alerte basés sur un autre type d’ondes, appelé phase W, ont été développés. La phase W a une bien meilleure sensibilité à la magnitude que les ondes P, mais se propage beaucoup plus lentement. On l’enregistre entre 10 et 30 minutes après l’origine du séisme, soit peu de temps avant l’arrivée du tsunami.

La découverte des signaux gravitationnels

En 2017, des signaux jusqu’alors inconnus ont été découverts. Ces signaux, appelés PEGS pour « prompt elasto-gravity signals » (signaux élasto-gravitationnels soudains), ont laissé entrevoir une possibilité nouvelle d’estimer plus rapidement et de manière plus fiable la magnitude des grands séismes. Lorsqu’un séisme se produit, une immense masse de roche est mise en mouvement de manière soudaine. Cette masse de roche en mouvement engendre une perturbation du champ de gravité terrestre (la pesanteur). Cette perturbation est extrêmement faible, mais se propage à la manière d’une onde gravitationnelle, à la vitesse de la lumière. De manière instantanée à l’échelle de la Terre. La gravité étant une accélération et les sismomètres enregistrant l’accélération du sol, les PEGS sont enregistrés par nos instruments de mesure « classiques ». De plus, ces signaux sont très sensibles à la magnitude, beaucoup plus que les ondes P dans le cas des grands événements.

Les PEGS disposent donc des caractéristiques idéales pour alimenter un système d’alerte. Cependant, leur détection est rendue difficile par leur très faible amplitude. (environ un million de fois plus faibles que les ondes P). Comment exploiter des signaux si faibles pour alerter ?

Une IA pour exploiter les signaux gravitationnels

La technologie émergente de l’IA s’avère très performante pour extraire rapidement des signaux faibles dans de grands volumes de données bruitées. Nous avons développé un algorithme d’IA qui estime toutes les secondes la magnitude du séisme en cours à partir des PEGS]Il est donc nécessaire de mettre au point de nouveaux systèmes plus fiables et rapides, afin d’avoir une stratégie de mise à l’abri la plus efficace possible. Nous avons développé un algorithme d’intelligence artificielle (IA), se basant sur des ondes d’origine gravitationnelle se propageant à la vitesse de la lumière, pour estimer de manière plus rapide et plus fiable la magnitude des grands séismes., publié très récemment dans Nature. Comme les grands séismes sont rares, nous avons simulé des centaines de milliers de scénarios de séismes possibles le long des grandes failles japonaises.

[Plus de 85 000 lecteurs font confiance aux newsletters de The Conversation pour mieux comprendre les grands enjeux du monde. Abonnez-vous aujourd’hui]

Dans chaque scénario, nous avons calculé les PEGS attendus sur tous les sismomètres de la région et entraîné l’IA à « trouver » la magnitude et la localisation du séisme en lui donnant la réponse à chaque fois. Nous avons ensuite testé la performance de l’IA sur les données enregistrées lors du séisme de Fukushima. Les résultats indiquent que l’on aurait pu estimer la magnitude du séisme dès la fin de la rupture (soit 2 minutes après l’origine de l’événement), et donc obtenir très rapidement une bien meilleure estimation de la hauteur de la vague.

Les résultats étant encourageants, nous passons désormais à la phase d’implémentation de l’algorithme dans un système d’alerte opérationnel, en commençant par le Pérou où l’on attend un très gros évènement (qui pourrait intervenir demain comme dans 300 ou 600 ans). Nous travaillons également à améliorer les performances de l’algorithme pour les séismes de magnitude plus modérée. Il fonctionne dans sa version actuelle pour les séismes de magnitude supérieure à 8,3, ce qui le rend déjà très utile pour l’estimation des tsunamis (qui ne concernent que ces très grands séismes) mais limite grandement les possibilités pour alerter sur les secousses (car ces dernières sont ressenties dans la plupart des cas avant que le séisme n’atteigne une telle magnitude).

Enfin, nous ambitionnons de développer une version mondiale de cet algorithme qui utiliserait des sismomètres pour alerter sur des séismes se produisant partout sur Terre, offrant ainsi une « couverture » d’alerte mondiale particulièrement intéressante pour des régions peu équipées.![]()

Quentin Bletery, Géophysicien, chargé de Recherche IRD au laboratoire Géoazur., Institut de recherche pour le développement (IRD)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.