Face aux problèmes d’accessibilité qui touchent un nombre croissant de personnes sourdes, les chercheurs s’intéressent aux nouvelles technologies pour l’apprentissage des langues des signes. Dans le domaine du numérique, les recherches se focalisent aujourd’hui sur le développement d’intelligences artificielles (IA) permettant de traduire automatiquement une langue vocale écrite ou parlée en langue des signes et vice-versa, en utilisant des avatars signant en 3D.

Les applications visées concernent notamment la traduction automatique qui permet de produire du contenu en langue des signes à partir de texte (SMS, contenu web…) ou de parole, de sous-titrer textuellement des vidéos en langue des signes, ou encore de concevoir des applications pédagogiques et des videobooks destinés aux enfants sourds. Faciliter la communication des personnes sourdes et leur accès à l’information et ainsi favoriser leur inclusion dans la société est l’objectif premier de ces travaux.

Des contraintes propres aux langues des signes

Les langues des signes sont des langues à part entière qui constituent des piliers de l’identité et des cultures sourdes. Il existe autant de langues des signes que de communautés de personnes sourdes, avec leurs déclinaisons nationales, leurs spécificités et leurs variantes régionales. Elles sont pratiquées non seulement par les personnes sourdes, mais également par toutes les personnes faisant partie de leur environnement familial, éducatif et professionnel. La langue des signes française (LSF) est la langue gestuelle pratiquée par les personnes sourdes de France. Longtemps interdite, elle n’a été reconnue qu’en 2005, ce qui peut expliquer le fait qu’elle soit peu dotée en matière de ressources telles que des ouvrages de référence lexicographiques, grammaticaux, voire encyclopédiques, ou encore des données numériques annotées.

Les rares bases de données de langues des signes existantes sont généralement constituées de vidéos, éventuellement accompagnées de traductions en langue vocale écrite. C’est vrai en particulier pour la LSF qui dispose essentiellement de dictionnaires lexicaux accessibles sur le Web. De plus, il n’existe pas de consensus dans la communauté internationale travaillant sur les langues des signes pour en définir une forme écrite. Il est donc difficile de procéder, comme pour les langues vocales, à l’alignement entre une vidéo en langue des signes et le texte correspondant. Le développement d’outils numériques dédiés aux langues des signes soulève par conséquent des enjeux linguistiques et technologiques importants.

Des spécificités linguistiques

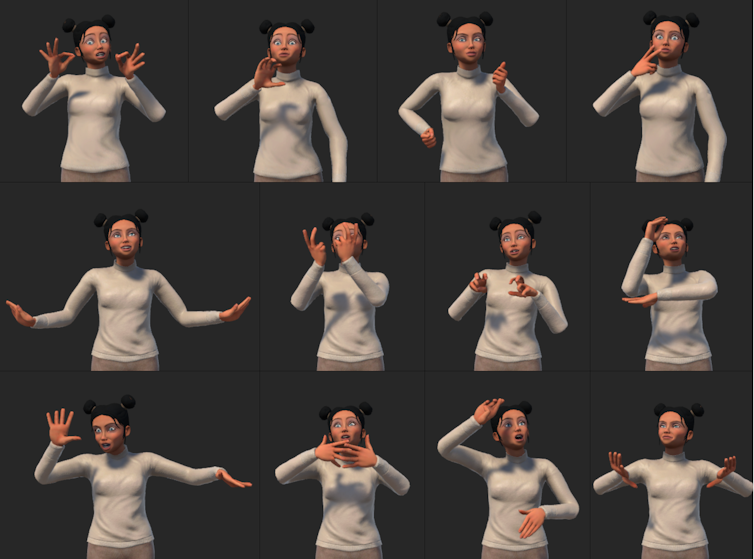

Avec des grammaires qui leur sont propres, les langues des signes viennent bouleverser les théories associées aux langues vocales ou écrites. Portées par les modalités visuelle et gestuelle, elles sont caractérisées par la mise en parallèle et la simultanéité des mouvements et des configurations des mains, mais aussi des mouvements non manuels incluant l’orientation du buste, les expressions faciales et la direction du regard.

De plus elles s’appuient sur des dynamiques iconiques et spatiales. Ainsi, le locuteur sourd déploie son discours dans l’espace qui l’avoisine : il positionne par ses gestes les entités de son discours, animées ou non, à des emplacements spécifiques de l’espace qui permettent de référencer et de rappeler ces entités.

L’iconicité, qui s’exprime par une relation de ressemblance entre le geste et ce qu’il signifie, se manifeste de différentes façons. Certaines configurations manuelles, porteuses de sens, peuvent représenter des signes lexicaux (un avion, une personne), ou être insérées dans un énoncé. Par exemple, la phrase « l’avion décolle » est représentée en LSF par un seul signe réalisé à deux mains : l’une des mains (forme plate) représente la piste statique, l’autre main, dynamique, représente l’avion dont le mouvement suit sa trajectoire relativement à la piste.

Ces caractéristiques iconiques et spatiales, omniprésentes dans les langues des signes, supposent des mécanismes grammaticaux qui exploitent la géométrie dans l’espace ainsi que la temporalité des mouvements. Cela constitue un défi technique à relever pour la synthèse des mouvements.

Créer des avatars signant animés avec la motion capture

D’un point de vue numérique, la vidéo, qui reste le média privilégié des sourds, ne permet pas de garantir l’anonymat et impose de fortes contraintes au niveau du stockage et du transport des données. Une réponse adaptée pour la production de langue des signes se trouve dans les avatars signant, des personnages virtuels animés en 3D capables de signer des énoncés. Grâce à des interfaces 3D interactives intégrant ces avatars, il devient alors possible d’éditer les animations, de les ralentir, de les rejouer, de changer de point de vue ou de zoomer sur des parties spécifiques du corps de l’avatar, voire de modifier son apparence graphique. Concevoir de tels avatars signant nécessite d’enregistrer au préalable les mouvements d’une personne sourde par des techniques de capture de mouvement (motion capture ou mocap) et d’adapter ces données à un modèle de personnage 3D.

Au cours de la dernière décennie, la traduction d’un texte en une animation signée a été réalisée grâce à des algorithmes s’appuyant sur des données de mocap. Ces algorithmes permettent de synthétiser de nouveaux énoncés par concaténation de mouvements existants. Si ces approches sont satisfaisantes en termes de précision et de qualité de la langue des signes produite, elles nécessitent des traitements des données de mocap très longs, fastidieux et complexes à automatiser. De plus, la création de nouveaux énoncés reste contrainte par le vocabulaire et les structures grammaticales des énoncés initialement enregistrés. Avec ce type de technologie, il semble difficile de construire de grands corpus de données avec des phrases contenant des variations sémantiques dans des domaines thématiques diversifiés.

Générer du contenu en langue des signes avec des IA génératives

Les avancées récentes des IA génératives dans le domaine de la génération de textes, d’images ou de vidéos ouvrent des perspectives évidentes en matière de traduction entre langue vocale (parlée ou écrite) et langue des signes. Les travaux de recherche actuels visent à intégrer ces avancées en développant des architectures de réseaux de neurones profonds adaptées au traitement automatique des langues. Grâce à des algorithmes d’apprentissage automatique, ces derniers apprennent, en exploitant de grandes bases de données, à identifier et reconnaître les tendances et les corrélations cachées dans les données afin de produire de grands modèles de langue de plus en plus efficaces et polyvalents.

Dans le cadre des langues des signes, les réseaux de neurones apprennent en parallèle et en contexte les caractéristiques linguistiques (par exemple une configuration manuelle) et cinématiques (par exemple une séquence de postures de squelette 2D ou 3D) extraites respectivement des phrases et des mouvements.

L’IA au service de l’insertion des personnes sourdes

Si les performances de ces systèmes, notamment en termes de précision des animations produites, peuvent être améliorées dans un futur proche, ils permettent d’ores et déjà d’augmenter considérablement les ressources disponibles, notamment en remplaçant les vidéos par des animations d’avatars 3D de haute résolution. De plus, des méthodes qualifiées de bout en bout (end to end) permettront de concevoir un réseau neuronal global pour des tâches complexes de traduction d’une langue vers une autre.

À court terme, il devient possible d’inclure ce type d’outil numérique de traduction automatique dans des applications pédagogiques exploitant les logiques respectives des grammaires en langues vocale et signée, favorisant ainsi l’apprentissage coordonné des deux langues. Ces ressources langagières et ces outils numériques sont indispensables pour assurer l’accès des personnes sourdes aux parcours éducatifs, passages obligés pour l’acquisition des connaissances et des compétences nécessaires à une insertion réussie dans la société.

Le projet SignToKids est soutenu par l’Agence nationale de la recherche (ANR), qui finance en France la recherche sur projets. Elle a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.![]()

Sylvie Gibet, Professeure des universités en informatique, Université Bretagne Sud

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.