Notre société change. De plus en plus, nous accueillons une nouvelle espèce parmi nous. Les robots.

Développer des interactions entre humains et robots n’est pas seulement un défi robotique mais aussi un défi pour comprendre les humains et la société humaine : comment les humains perçoivent les robots, communiquent avec eux, se comportent autour d’eux et les acceptent (ou non). Cela devient d’autant plus important avec l’arrivée de la quatrième génération de robots, qui s’intègrent directement au corps humain.

Nous travaillons à mieux comprendre ce qu’on appelle « l’incarnation » de ces dispositifs : en effet, à mesure que ces robots en viennent à « ne faire qu’un » avec nous, ils modifient nos comportements et notre cerveau.

La première génération d’interactions humain-robot, pour l’industrie

Ce « voyage dans le temps » des robots, passés du statut de machines dangereuses à celui de partie intégrante de la société humaine, dure depuis plus de quarante ans.

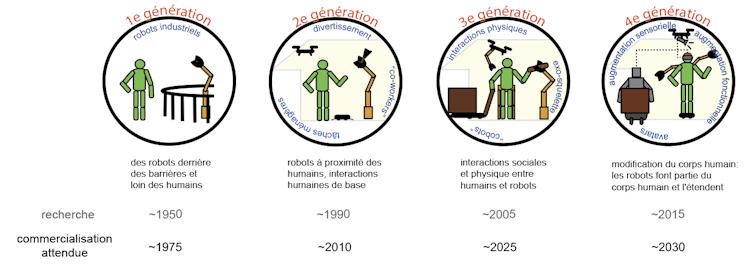

Les robots sont très variés, de par leurs tailles (micrométriques voire nanométriques d’un côté, mais de taille humaine ou plus de l’autre), leurs manières de bouger et leurs fonctionnalités (industrielles, spatiales, de défense par exemple). Ici, je ne me concentre pas sur les robots eux-mêmes, mais sur les interactions entre humains et robots qui, selon moi, se sont développées sur quatre générations.

Les interactions entre humains et robots à grande échelle ont commencé avec l’arrivée des robots industriels, dont le premier a été introduit par General Motors en 1961. Ceux-ci se sont lentement répandus et au début des années 1980, les robots industriels étaient présents aux États-Unis, en Europe et au Japon.

Ces robots industriels ont permis d'observer la première génération d’interactions humain-robot : ils opèrent généralement dans des zones délimitées, pour s’assurer que les humains ne s’approchent pas d’eux, même par erreur.

Les robots industriels, qui ont d’abord été popularisés par les tâches d’assemblage automobile, sont maintenant utilisés pour diverses tâches, telles que le soudage, la peinture, l’assemblage, le démontage, le pick and place pour les cartes de circuits imprimés, l’emballage et l’étiquetage.

Travailler côte à côte

La recherche en robotique de cette période s’est concentrée sur le rapprochement des robots avec les humains, ce qui a donné lieu à une deuxième génération d’interactions humain-robot, matérialisée pour le grand public au début des années 2000, lorsque des machines, comme le Roomba et l’Aibo, ont commencé à entrer dans nos maisons.

Ces robots de deuxième génération travaillent à proximité des humains dans nos maisons et nos bureaux pour des « applications de service », telles que le nettoyage des sols, la tonte des pelouses et le nettoyage des piscines – un marché d’environ 13 milliards de dollars US en 2019. En 2009, il y avait environ 1,3 million de robots de service dans le monde ; un nombre qui avait augmenté en 2020 à environ 32 millions.

Toutefois, bien que ces robots opèrent dans un environnement plus humain que les robots industriels, ils interagissent toujours de manière assez minimale et basique. La plupart de leurs tâches quotidiennes sont des tâches indépendantes, qui nécessitent peu d’interaction. En fait, ils essaient même souvent d’éviter les interactions avec les humains – ce qui n’est pas toujours aisé.

Interagir avec les humains

La relation entre humains et robots évolue désormais progressivement vers la troisième génération d’interactions. Les robots de la troisième génération ont la capacité d’interagir cognitivement ou socialement comme les robots dits « sociaux », mais aussi physiquement comme les exosquelettes.

Des robots capables d’assistance physique, qui pourraient être utilisés pour la rééducation et les soins aux personnes âgées, l’assistance sociale et la sécurité, ont par ailleurs été clairement identifiés comme prioritaires par les gouvernements en Europe, aux Etats-Unis ainsi qu'au Japon dès le milieu des années 2010.

Une façon notamment de répondre au problème du vieillissement des populations dans ces pays développés.

Contester la définition du corps humain

Nous voyons désormais lentement l’émergence d’une quatrième génération d’interactions humain-robot, dans laquelle les robots ne sont pas seulement physiquement proches des humains, mais bien connectés au corps humain lui-même. Les robots deviennent des extensions du corps humain.

C’est le cas des dispositifs d’augmentation fonctionnelle -tels que des membres robotiques surnuméraires- ou encore des dispositifs de remplacement fonctionnels tels que les avatars de robots (qui permettent à l'homme d'utiliser un corps de robot pour lui faire réaliser des tâches précises). D'autres dispositifs peuvent également fournir une perception sensorielle supplémentaire aux humains.

Les interactions de quatrième génération sont fondamentalement différentes des autres générations en raison d’un facteur crucial : avant cette génération, l’humain et le robot sont clairement définis dans toutes leurs interactions par les limites physiques de leurs corps respectifs, mais cette frontière devient floue dans les interactions de quatrième génération, où les robots modifient et étendent le corps humain en termes de capacités motrices et sensorielles.

En particulier, les interactions de la quatrième génération devraient interférer avec ces « représentations corporelles ». On sait qu’il existe des représentations spécifiques de notre corps dans notre cerveau qui définissent la façon dont notre cerveau reconnaît notre corps. Ces représentations déterminent notre cognition et nos comportements.

Par exemple, imaginez que vous faites vos courses dans une allée d’épicerie bondée. Pendant que vous atteignez des articles avec votre main droite, vous êtes capable, très implicitement et sans même vous en rendre compte d’éviter la collision de votre bras gauche avec les autres acheteurs.

Ceci est possible car votre cerveau a une représentation de la taille, de la forme de vos membres et est conscient et surveille chacun de vos membres. Si vous tenez un panier dans votre bras (ce qui change la taille et la forme du « bras »), vous aurez plus de difficultés à éviter instinctivement les collisions, et devrez faire un effort conscient pour que le panier ne heurte rien dans votre entourage proche.

De la même manière, notre cerveau peut-il s’adapter à un membre surnuméraire, ou autre addition robotique de quatrième génération, et mettre à jour ses représentations corporelles ? C’est ce que l’on appelle l’« incarnation » en neurosciences.

Si l’incarnation de ces dispositifs peut se produire, à quelle vitesse cela se produit-il ? Quelles sont les limites de cette incarnation ? Comment cela affecte-t-il notre comportement et le cerveau lui-même ?

Les interactions humain-robot de quatrième génération ne remettent pas seulement en question l’acceptation de la machine par le cerveau de l’utilisateur, mais aussi l’acceptation de l’utilisateur dans la société : on ne sait toujours pas si notre société acceptera, par exemple des individus avec des bras robotiques supplémentaires. Cela dépendra certainement d’aspects culturels que nous essayons également d'analyser.

En réalité, les robots de troisième et quatrième génération sont si proches des humains que nous devons mieux comprendre les comportements humains et notre cerveau pour les développer.

Dans nos travaux, nous combinons donc la recherche en robotique avec les neurosciences cognitives, motrices et sociales, pour développer ce que nous croyons être la science des interactions humain-machine.

C'est seulement grâce à une compréhension holistique des individus humains, des machines qui interagissent avec eux et de la société dans laquelle ils vivent, que nous pourrons développer les futures générations de robots. Et, dans un sens, la société du futur.![]()

Ganesh Gowrishankar, Chercheur au Laboratoire d'Informatique, de Robotique et de Microelectronique de Montpellier, Université de Montpellier

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.