Aujourd’hui, on peut lire vos émotions sur votre visage et adapter un flux vidéo en temps réel en fonction de votre réaction. Vraiment ? Quelles sont les utilisations autorisées de l’« emotion AI », et ses limites ? Éclairage par deux spécialistes.

Dans un magasin de cosmétiques, une cliente s’arrête devant une borne interactive. Une caméra intégrée filme son visage pendant quelques secondes pendant qu’elle regarde l’écran. Le système ne cherche pas à l’identifier, mais à observer ses réactions : sourit-elle ? détourne-t-elle le regard ? fronce-t-elle légèrement les sourcils ? À partir de ces signaux, la borne adapte le contenu affiché.

Ces technologies, qui s’inscrivent dans le domaine de l’emotion AI, sont déjà utilisées pour tester des publicités, analyser l’attention d’un public lors d’une conférence ou mesurer l’engagement face à une interface.

Mais que fait réellement cette technologie lorsqu’elle « analyse » un visage ? Et jusqu’où peut-on aller lorsqu’on cherche à interpréter des expressions faciales à l’aide de l’intelligence artificielle ?

Qu’est-ce que l’« emotion AI » ?

L’emotion AI désigne un ensemble de méthodes informatiques qui consistent à analyser des expressions faciales afin d’en extraire des informations sur les réactions émotionnelles probables d’une personne.

Dans la pratique, ces systèmes captent les mouvements du visage : ouverture de la bouche, haussement des sourcils, plissement des yeux, dynamique des expressions dans le temps. L’objectif n’est pas de savoir ce qu’une personne ressent au fond d’elle-même, mais d’associer ces indices faciaux à certaines réactions comme l’intérêt, la surprise ou le désengagement. Les résultats prennent la forme de scores ou de catégories, qui indiquent la probabilité qu’une expression corresponde à un état donné.

Cette approche s’inscrit dans une longue tradition de recherche sur les expressions faciales, bien antérieure à l’intelligence artificielle. Dès les années 1970, des travaux fondateurs en psychologie ont proposé des méthodes systématiques pour décrire et coder les mouvements du visage, reposant sur des observations humaines expertes.

Ce que l’emotion AI apporte, c’est la capacité à automatiser l’analyse, à grande échelle et en temps quasi réel de ces signaux, que les chercheurs et praticiens étudient depuis longtemps de manière manuelle ou semi-automatisée. Cette automatisation s’est développée à partir des années 2000 avec l’essor de la vision par ordinateur, puis s’est accélérée avec les méthodes d’apprentissage automatique et d’apprentissage profond.

Comment ça marche ?

Les systèmes actuels analysent des flux vidéo image par image, à des fréquences comparables à celles de la vidéo standard. Selon la complexité des modèles et le matériel utilisé, l’estimation des réactions faciales peut être produite avec une latence de l’ordre de la centaine de millisecondes, ce qui permet par exemple d’adapter dynamiquement le contenu affiché sur une borne interactive.

Le logiciel détecte d’abord un visage à l’écran, puis suit les changements de son expression d’une image à l’autre. À partir de ces informations, le système calcule des descripteurs faciaux, puis les compare à des modèles appris à partir de bases de données d’expressions faciales annotées, c’est-à-dire des ensembles d’images ou de vidéos de visages pour lesquelles des experts humains ont préalablement identifié et étiqueté les mouvements ou expressions observés.

En effet, lors de la phase d’apprentissage du modèle d’IA, le système a appris à associer certaines configurations faciales à des catégories ou à des scores correspondant à des réactions données. Lorsqu’il est ensuite appliqué à un nouveau visage, il ne fait que mesurer des similarités statistiques avec les données sur lesquelles il a été entraîné.

Concrètement, lorsqu’un système indique qu’un visage exprime une émotion donnée, il ne fait que dire ceci : « cette configuration faciale ressemble, statistiquement, à d’autres configurations associées à cet état dans les données d’entraînement » (on parle d’inférence probabiliste).

Ces méthodes ont aujourd’hui atteint un niveau de performance suffisant pour certains usages bien définis – par exemple lors de tests utilisateurs, d’études marketing ou dans certaines interfaces interactives, où les conditions d’observation peuvent être partiellement maîtrisées.

Quelles sont les limites techniques ?

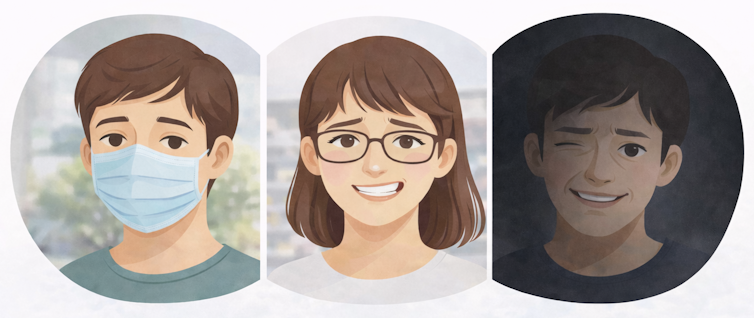

Néanmoins, cette fiabilité reste très variable selon les contextes d’application et les objectifs poursuivis. Les performances sont en effet meilleures lorsque le visage est bien visible, avec un bon éclairage, peu de mouvements et sans éléments masquant les traits, comme des masques ou des lunettes à monture épaisse. En revanche, lorsque ces systèmes sont déployés en conditions réelles et non contrôlées, leurs résultats doivent être interprétés avec davantage d’incertitude.

Les limites de l’emotion AI tiennent d’abord à la nature même des expressions faciales. Une expression ne correspond pas toujours à une émotion unique : un sourire peut signaler la joie, la politesse, l’ironie ou l’inconfort. Le contexte joue un rôle essentiel dans l’interprétation.

Les performances des systèmes dépendent également des données utilisées pour les entraîner. Les bases de données d’entraînement peu diversifiées peuvent conduire entre autres à des erreurs ou à des biais. Par exemple, si la base de données est principalement composée d’images de femmes de moins de 30 ans de type caucasien, le système aura du mal à interpréter correctement des mouvements faciaux d’individus de plus de 65 ans et de type asiatique.

Enfin, il ne faut pas se limiter aux seules expressions faciales, qui ne constituent qu’un canal parmi d’autres de l’expression émotionnelle. Elles fournissent des informations précieuses, mais partielles. Les systèmes d’emotion AI sont donc surtout pertinents lorsqu’ils sont utilisés en complément d’autres sources d’information, comme des indices vocaux, comportementaux ou déclaratifs. Cette approche ne remet pas en cause l’automatisation, mais en précise la portée : l’emotion AI automatise l’analyse de certains signaux observables, sans prétendre à une interprétation exhaustive des émotions.

Des risques à ne pas ignorer

Utilisée sans cadre clair, l’emotion AI peut alimenter des usages problématiques, notamment lorsqu’elle est intégrée à des dispositifs d’influence commerciale ou de surveillance.

Dans le domaine commercial, ces technologies sont par exemple envisagées pour ajuster en temps réel des messages publicitaires ou des interfaces en fonction des réactions faciales supposées des consommateurs. Ce type de personnalisation émotionnelle soulève des questions de manipulation, en particulier lorsque les personnes concernées ne sont pas pleinement informées de l’analyse de leurs réactions.

Les risques sont également importants dans les contextes de surveillance, notamment lorsque l’analyse automatisée des expressions faciales est utilisée pour inférer des états mentaux ou des intentions dans des espaces publics, des environnements professionnels ou des contextes sécuritaires. De tels usages reposent sur des inférences incertaines et peuvent conduire à des interprétations erronées, voire discriminatoires.

Ces risques sont aujourd’hui largement documentés par la recherche scientifique, ainsi que par plusieurs institutions publiques et autorités de régulation. À l’échelle internationale, ces réflexions ont notamment conduit à l’adoption de recommandations éthiques, comme celles portées par l’Unesco, qui ne sont toutefois pas juridiquement contraignantes et visent surtout à orienter les pratiques et les politiques publiques.

En revanche, en Europe, le règlement sur l’IA interdit ou restreint fortement les usages de l’analyse émotionnelle automatisée lorsqu’ils visent à surveiller, classer ou évaluer des personnes dans des contextes grand public, notamment dans les espaces publics, au travail ou à l’école.

Ces technologies ne peuvent pas être utilisées pour inférer des états mentaux ou guider des décisions ayant un impact sur les individus, en raison du caractère incertain et potentiellement discriminatoire de ces inférences. En France, la mise en œuvre de ce cadre s’appuie notamment sur l’action de la Commission nationale de l’informatique et des libertés (Cnil), chargée de veiller au respect des droits fondamentaux dans le déploiement de ces technologies.

Ces débats rappellent un point essentiel : les expressions faciales ne parlent jamais d’elles-mêmes. Leur analyse repose sur des inférences incertaines, qui exigent à la fois des modèles théoriques solides, une interprétation critique des résultats et un cadre d’usage clairement défini.

Les enjeux éthiques et réglementaires ne sont donc pas extérieurs aux questions scientifiques et techniques, mais en constituent un prolongement direct. C’est précisément dans cette articulation entre compréhension fine des expressions, limites des modèles et conditions d’usage responsables que se joue l’avenir de l’emotion AI.![]()

Charlotte De Sainte Maresville, Doctorante 3 eme année en marketing et sciences affectives, Université Bretagne Sud (UBS) et Christine Petr, Professeur des Université en Marketing - Sciences de Gestion et du Management, Université Bretagne Sud (UBS)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.